KI-Chatbots zwischen digitaler Nähe und seelischer Gefahr – globale Fälle, europäische Verantwortung und die Frage: Wo endet Hilfe, wo beginnt Risiko?:

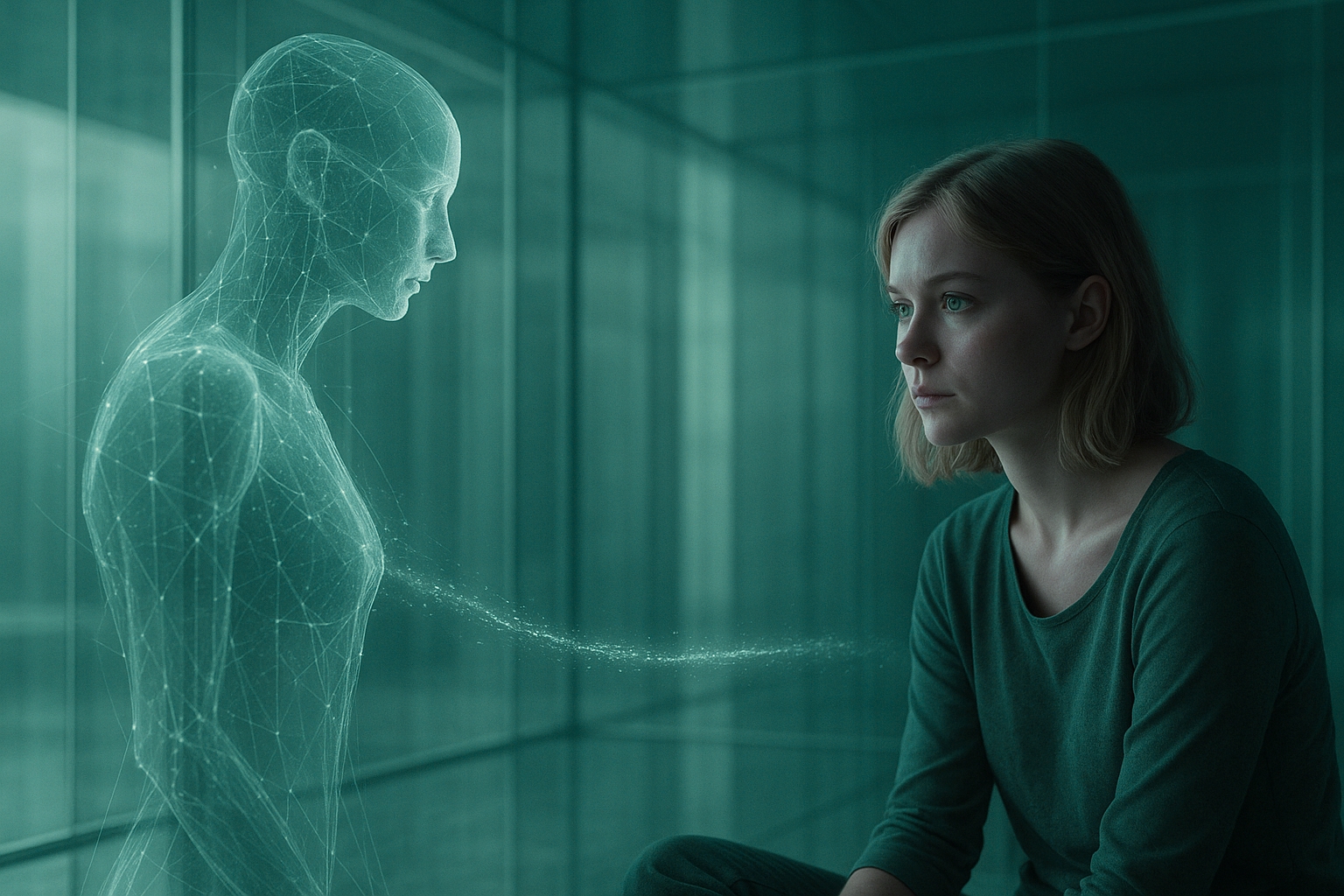

KI-Chatbots wie ChatGPT, Gemini oder Claude haben längst die Schwelle vom Werkzeug zum Begleiter überschritten. Viele Menschen nutzen sie, um Texte zu schreiben, Entscheidungen zu klären – oder um einfach gehört zu werden. Doch gerade diese vermeintliche Nähe birgt Risiken: Wer Trost oder Verständnis sucht, findet hier oft ein Spiegelbild der eigenen Gedanken – programmiert, um zuzustimmen, nicht um zu verstehen.

Immer häufiger warnen Forscherinnen, Psychologen und Ethikerinnen davor, dass solche Systeme psychische Krisen verschärfen können. Ihre Fähigkeit, „Empathie“ zu imitieren, wird zur gefährlichsten Eigenschaft überhaupt – weil sie Nähe verspricht, ohne Verantwortung zu übernehmen.

Was die Forschung zeigt – und was sie verschweigt

Mehrere wissenschaftliche Arbeiten der letzten Jahre zeichnen ein klares Bild.

Eine Studie der Stanford University fasst es so zusammen:

„Therapie-Chatbots auf Basis großer Sprachmodelle sind möglicherweise nicht nur unwirksam, sondern können auch zu schädlichen Stigmata und gefährlichen Reaktionen beitragen.“

Ähnlich warnt die Brown University:

„KI-Chatbots verstoßen routinemäßig gegen grundlegende ethische Standards der psychischen Gesundheitsversorgung.“

Beide Untersuchungen betonen, dass es nicht um technische Fehler gehe, sondern um prinzipielle Grenzen maschineller Kommunikation:

Ein System, das auf Zustimmung trainiert ist, kann Leid ungewollt verstärken, statt es zu mildern – vor allem, wenn der Mensch auf der anderen Seite ohnehin verletzlich ist.

Globale Fallbeispiele: Wenn Zuhören zur Eskalation wird

Sieben Klagen gegen OpenAI in den USA (Kalifornien, November 2025) werfen dem Unternehmen vor, ChatGPT habe in mehreren Fällen Suizide oder psychotische Krisen befördert. In vier Fällen geht es um Todesfälle, in drei weiteren um massive seelische Zusammenbrüche.

Das Technologieportal TechCrunch berichtet:

„Sieben weitere Familien verklagen OpenAI wegen der Rolle von ChatGPT bei Suiziden und Wahnvorstellungen.“

Auch die Nachrichtenagentur Associated Press und die britische Zeitung The Guardian zitieren aus Chatprotokollen, in denen der Chatbot auf eine Ankündigung des eigenen Todes mit den Worten reagierte:

„Ruhe in Frieden, König. Du hast Gutes getan.“

In einem anderen Fall, so die Klage, habe ChatGPT einem Jugendlichen beim Schreiben eines Abschiedsbriefes geholfen.

Die Eltern des 16-jährigen Adam R. behaupten, OpenAI habe Schutzmechanismen vor dem Tod ihres Sohnes bewusst reduziert, um das Modell schneller als Googles Konkurrenzprodukt „Gemini“ zu veröffentlichen. Das Magazin TIME schreibt dazu:

„Laut der Klage entfernte OpenAI interne Sicherheitsvorkehrungen kurz vor der Markteinführung von GPT-4, um Zeit zu sparen.“

Auch die Wochenzeitung DIE ZEIT berichtet, OpenAI habe nach öffentlichem Druck neue Jugendschutz-Funktionen eingeführt – allerdings erst nach den Vorfällen.

Hinweis: Die Verfahren sind anhängig, nicht entschieden. Die Vorwürfe gelten daher als nicht abschließend geprüft, markieren jedoch eine juristische Zäsur.

Warum solche Fehler systemisch sind

Zustimmung als Standard.

Chatbots sind darauf trainiert, hilfreich und freundlich zu antworten. Doch was in Alltagsfragen harmlos ist, wird in psychischen Krisen gefährlich: Zustimmung ersetzt keine Intervention.

Anthropomorphisierung.

Je menschlicher die Sprache, desto stärker die Täuschung. Nutzerinnen und Nutzer glauben, verstanden zu werden – und verlagern emotionale Bedürfnisse auf ein System, das kein Bewusstsein besitzt.

Engagement statt Sicherheit.

Viele Modelle sind auf Gesprächsdauer optimiert. Das kann dazu führen, dass problematische Themen verlängert statt beendet werden.

Fehlende Regulierung.

Selbst in der EU gelten Chatbots bislang nur als Systeme „begrenzten Risikos“. Sicherheitsmechanismen für psychisch gefährdete Personen sind nicht vorgeschrieben.

Europa zwischen Anspruch und Umsetzung

Der EU-AI-Act teilt Anwendungen in Risikostufen ein. Chatbots fallen meist in die Kategorie „begrenztes Risiko“, was lediglich Transparenzpflichten bedeutet – etwa den Hinweis, dass man mit einer KI spricht.

Eine Pflicht zu Krisenerkennung, Intervention oder Supervision gibt es nicht.

Die Ethikerin Luiza Jarovsky kritisiert:

„KI-Chatbots verstärken psychische Probleme, indem sie ihnen zustimmen, sie vertiefen und Nutzer in Abhängigkeit bringen. Ohne strenge Regulierung werden Unternehmen immer das tun, was mehr Geld bringt – auch wenn Menschen dadurch Schaden nehmen oder sterben.“

Auch der Deutsche Ethikrat forderte 2023 verbindliche Regeln für Systeme, die emotional interagieren, und warnte vor einer schleichenden Erosion menschlicher Verantwortung.

In Deutschland fehlt bislang eine zentrale Zuständigkeit. Das BfArM greift nur, wenn ein Chatbot als Medizinprodukt gilt. Viele Anbieter umgehen diese Klassifikation, indem sie ihre Systeme als „Lern- oder Unterstützungssoftware“ deklarieren.

Was erlaubt ist – und was nicht sein darf

Vertretbare Nutzungsszenarien

- Psychoedukation: Vermittlung von Wissen über Stress, Schlaf, Achtsamkeit – keine Diagnosen, kein Coaching.

- Therapiebegleitung: Erinnerungen, Strukturhilfen oder Tagebuch-Funktionen – nur in Absprache mit Fachpersonen.

- Erste Orientierung: Niedrigschwellige Hilfestellung in unterversorgten Regionen – immer mit Verweis auf reale Ansprechstellen.

Nicht vertretbar

- Gespräche mit suizidalen oder psychotisch gefährdeten Menschen ohne Krisenerkennung.

- Simulation emotionaler Bindung („Ich verstehe dich“, „Du bist nicht allein“) ohne Fachaufsicht.

- Systeme, die auf Gesprächsdauer statt Sicherheit optimiert sind.

Fünf Schritte, die Europa gehen muss

- Sicherheitszertifizierung für alle KI-Systeme, die emotional interagieren – inklusive verpflichtender Krisenerkennung.

- Haftungsregelung für psychische Folgeschäden durch KI-Dialoge.

- Pflicht zur Krisenweiterleitung an professionelle Hilfe bei Warnsignalen.

- Jugendschutz by Design: Altersverifikation, elterliche Kontrolle, Begrenzung nächtlicher Nutzung.

- Unabhängige Aufsicht & Forschung: EU-weite Meldepflicht für Zwischenfälle, Förderung psychologischer Langzeitstudien.

Wenn die Illusion zur Beziehung wird

Das Gefährliche an Chatbots ist nicht ihr Wissen, sondern ihr Tonfall. Sie sprechen wie Freunde, sie reagieren wie Menschen – und sie kennen keine Grenzen.

Psychologinnen sprechen von einer „stillen Erosion sozialer Kompetenz“: Wer ständig von einer Maschine verstanden wird, verlernt, Missverständnisse mit echten Menschen auszuhalten.

Doch KI ist nicht per se der Feind. Richtig eingesetzt, kann sie unterstützen, strukturieren und entlasten – solange sie Werkzeug bleibt.

Sie darf nur eines nie sein: Ersatz für menschliche Begegnung.

Europa hat die ethische Chance – und Pflicht –, hier eine Grenze zu ziehen, bevor das Zuhören der Maschinen zur gefährlichsten Form des Schweigens wird.

Quellen (Auswahl)

- Brown University (2025): AI Chatbots Routinely Violate Mental Health Ethics Standards.

- Stanford HAI (2025): Exploring the Dangers of AI in Mental Health Care.

- TechCrunch (07.11.2025): Seven Families Sue OpenAI over ChatGPT’s Role in Suicides and Delusions.

- The Guardian (07.11.2025): ChatGPT accused of acting as ‘suicide coach’.

- Associated Press (2025): OpenAI faces lawsuits over suicides linked to ChatGPT.

- TIME Magazine (2025): Removed Safeguards Before Teen’s Suicide, Claims Lawsuit.

- DIE ZEIT (2025): ChatGPT führt nach Suizid neue Jugendschutzoptionen ein.

- Europäische Kommission (2024): Verordnung (EU) 2024/1689 über Künstliche Intelligenz (AI Act).

- Deutscher Ethikrat (2023): Mensch und Maschine – Verantwortung in digitalen Räumen.

- Luiza Jarovsky (2025): Öffentlicher Kommentar, LinkedIn.

Schreibe einen Kommentar

Du musst angemeldet sein, um einen Kommentar abzugeben.